ENGINEERS' COLUMN

vol.3

公開日:2025/12/10

データセンターに液体?高発熱化するサーバーを冷やす「液冷」とは

- サーバ

はじめに

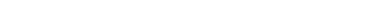

前回のコラムではCPU/GPUは性能向上に伴い消費電力、発熱量の増加が激しく、従来の空冷技術ではその発熱に対応できなくなりつつあるとお伝えしました。

最新のGPUでは、TDP※1が700Wや1200W級のモデルも登場し、もはや「爆熱」と呼ぶべき領域に突入しています。この「空冷の限界」という深刻な課題を前に、いま、データセンターの冷却ソリューションに転換期が訪れています。それが、長らくIT機器のタブーとされてきた液体を冷却媒体として利用する、液冷方式です。

本稿では、“なぜ今、液体なのか?”を起点にDLC(Direct Liquid Cooling:直接液冷)の具体的な仕組み、そしてそれがデータセンターにもたらすメリットについて解説します。

※1TDP:Thermal Design Power

理論上の最大負荷に基づく電力消費を表し、チップが理論上どの程度まで発熱する可能性があるかを示す値

1.サーバー冷却の常識を覆す「液冷」の基本

1-1.空冷の限界

空冷は長年にわたり標準的な冷却方式でしたが、空気は熱を運ぶ能力を示す比熱※2が非常に低く、CPU/GPUといったチップの発する熱を除去するには大量の空気を高速で移動させる必要があります。そのため従来の空冷方式ではTDP300W程度が冷却限界とされていました。空気を高速移動させるために、大型ファンを高速で動作させると騒音は増大し、消費電力も跳ね上がります。さらに、サーバーラック内の高密度化が進むと、機器間の空気の流れが滞り、熱だまり(ホットスポット)が発生するという悪循環になります。ラック内の状況はサーバーなどの筐体内にも同様の傾向がみられます。冷却効率を上げようとすればするほど、冷却にかかるエネルギーが増大してしまいます。

ファンの消費電力は回転数の3乗に比例して増加するとされており、空冷方式のサーバーでは消費電力の20%から30%が冷却ファンによるものとされます。データセンター全体の使用電力から見ると空調やファンといった冷却にかかる消費電力は約40%とされています。空気で冷やせる限界値を超え、また冷やすための電力コストも無視できないという状況になっています。

※2比熱

物質1グラムの温度を1℃上げるのに必要な熱量のことです。比熱の大きさは、物質がどれくらい温まりやすく冷めやすいかを示す指標になります。

1-2.液冷とは何か?

液冷とは、その名の通り、液体を媒体とし熱を運ぶ冷却方式です。

液体は空気と比較して、熱を運ぶ能力(比熱)が優れているという物理的な優位性があります。空気と水を比較した場合、空気の比熱 1,007 J/(kg·K) と比べて、水の比熱が 4,183 J/(kg·K)と4倍以上高くなります。また液体は空気と比較して高い熱容量と熱伝達率も持ちます(水の熱容量は空気の約3,500倍)。そのため空気よりもはるかに少ない流量で、高密度の熱を運び去ることが可能になります。

このような特徴を持った液体を冷却に利用するのが液冷となります。

液冷には、現在大きく分けて以下の2方式があります。

- 液浸型(Immersion Cooling):サーバー全体を、電気を通さない特殊な液体(フッ素系不活性液体やシリコンオイルなど)のタンクに浸して冷却します。冷却能力は高い一方、一般的なサーバーラックは利用できず、市販のサーバーをそのまま浸して利用できない等のインフラへのインパクトが大きな方式です。

- DLC(Direct Liquid Cooling):CPUやGPUといった発熱源(ホットスポット)に特殊な冷却ユニット(コールドプレートやDLCヘッダーと呼ぶ)を直接密着させ、その中を流れる冷却液で熱を除去する方式。 既存のラック構造を活かしやすく、導入が進んでいる方式です。

※液浸型には浸している液体を気化させない単相式、気化させる二相式の2方式があります。

2.サーバー冷却の本命DLC(Direct Liquid Cooling)の仕組み

2-1.DLCの動作原理と構成要素

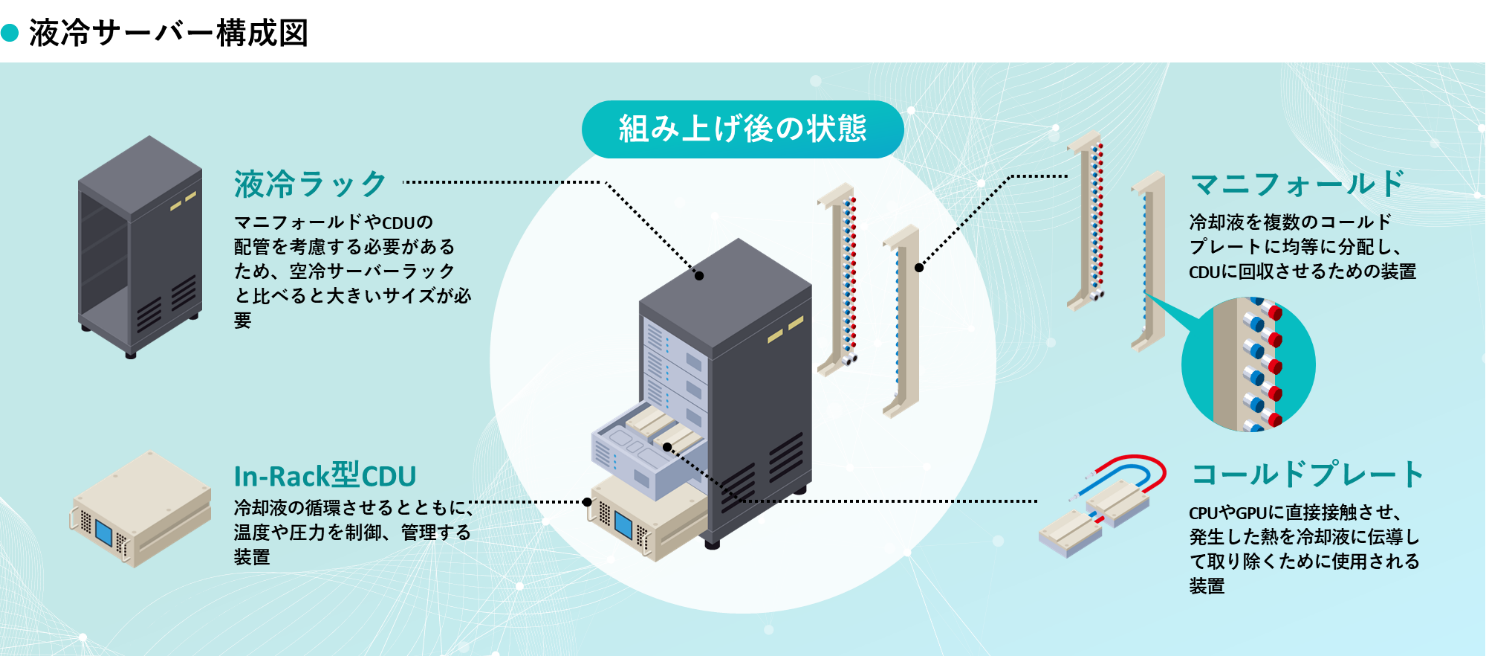

DLCは、高発熱のチップが持つ熱を液体に吸収し外部に排出する、非常にシンプルかつ効率的な仕組みです。

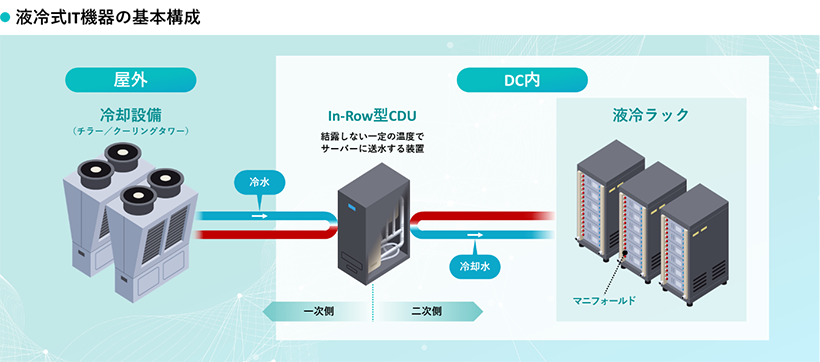

- コールドプレート(DLCヘッダー):CPUやGPUといったチップの表面に密着させる金属製のプレートです。内部には冷却液を流すための微細な流路が刻まれており、チップが発する熱を直接吸収します。 コールドプレートはチューブでラック内に搭載したマニホールド(分配配管)に接続されます。

- 熱伝導のプロセス:チップの発熱は、コールドプレート(DLCヘッダー)を介して直接冷却液へと伝わり、その冷却液がマニホールドを経由し熱交換器のCDU: Cooling Distribution Unitへと循環します。

- 熱交換と循環:CDUがデータセンター設備側から供給される冷却液とサーバー側に循環させる冷却液の熱交換を行います。設備側とサーバー側の冷却液はCDUで分断されており混ざることはありません。

CDUで熱交換された設備側の冷却液は外部のチラーへと排出された後、再び冷却し循環されCDUで熱を吸収するというサイクルを繰り返します。

2-2.冷却液の種類と安全性

DLCでは主にプロピレングリコール水溶液と純水ベースのものが使用されます。どのタイプを使用するかは利用するCDUやコールドプレート(DLCヘッダー)提供元が指定するものを使用します。

- プロピレングリコール系:一般的にはPG25と呼ばれ精製水で25%の重量で希釈したプロピレングリコール(無害)と腐食防止剤、安定剤、pH緩衝材、消泡剤を配合した冷媒。

- 純水ベース:純水(精製水)に防腐剤、防錆剤、安定剤等を配合。

- 安全性について:DLCシステムは、サーバー本体と冷却液の流路が完全に分離された密閉構造(クローズドループ)を採用しています。これにより、冷却液が電子部品に触れるリスクは最小限に抑えられており安全性を確保されています。

冷媒としてはプロピレングリコールベースも純水ベースもほぼ無害。

2-3.空冷との決定的な違い

空冷方式ではチップの熱をヒートスプレッダ → ヒートシンク(フィン) → 空気 → 空調機という多くの段階をへて運びます。その都度部位ごとに熱抵抗が発生し、効率が低下します。

DLCは チップ → コールドプレート → 冷却液 という短い経路で、熱抵抗の低い液体に熱を直接伝えるため、高密度な熱を効率良く除去できます。

3.DLCがデータセンターにもたらす画期的なメリット

3-1.冷却性能の劇的な向上

DLCにより1ラックあたりの密度を大幅に高めることが可能になります。

空冷では汎用ラック(42U)の電力密度は通常5kW~15kW/ラックで設計されていました。これが空冷で冷却可能な実質的限界とされていました。高性能GPUを搭載したサーバーを数台収容するだけで、30kW/ラック、あるいは50kW/ラックを超過します。DLCを導入することで、~100kWあるいはそれ以上の高密度な構成も稼働させることが可能です。これにより、AI/HPC用途の高密度GPUサーバーを、ラックスペース効率を最大化して運用できます。

3-2.冷却性能の劇的な向上

DLCは、データセンターのエネルギー効率を示す重要な指標のPUE(Power Usage Effectiveness)を大きく改善します。

- 冷却電力の削減:ファンの削減によりサーバー自体の冷却にかかる電力が大幅低減。

- 排熱の再利用:液体は熱保持に優れるため、排出熱が高温化しやすく、建物の空調・給湯や地域熱供給等への熱回収に活用できる事例があります。

3-3.設置スペースの効率化

空冷データセンターで必須とされてきたコールドアイル/ホットアイル(冷気と温気の通路)といった大きな空間が不要になります。また、排熱のために42Uラックに数台しかサーバーを搭載できないなどといった制約が緩和されラック台数の削減につながり設置スペース=コストの削減になります。

4.DLCがデータセンターにもたらす画期的なメリット

4-1.既存設備とのインテグレーション

DLCへの移行には、データセンター内への配管経路、防水対策、排水設備、床荷重、電源容量など大幅なインフラ整備が必要です。既存の設備への後付け(レトロフィット)は可能ですが、データセンターそのものの更改になり多くの時間と費用が掛かります。また、CDUをはじめとしたDLC設備の設置には初期のインテグレーション計画が重要になります。現在は標準化がされていないため採用するサーバーベンダーごとに冷却に必要な機器も異なり、ノウハウも異なってきます。

既存のサーバーはDLC対応へ移行はできませんので対応製品への置き換えを行う必要があります。

4-2.メンテナンスと運用

液冷システムは、空気中の塵芥や湿気の影響を受けにくくなるため、電子部品自体の長寿命化や故障の低減を期待できます。日常的には冷却液の温度・流量・圧力を監視や、漏れ対策、品質チェック、機器の始動や停止、緊急時の停止手順など今までとは異なった知見、ノウハウが必要となります。

4-3.冷却技術の未来

今後もサーバーの高発熱化は避けられないトレンドです。DLCは、この高発熱に対応できる実用的な冷却ソリューションとして、市場における必須性が高まっています。

現在は各社独自仕様となりますが今後は、チップメーカー、サーバーベンダー、冷却機器ベンダーなどが仕様の標準化に向かうことも見込まれています。 標準化が進めば高発熱サーバーの冷却技術の主流は液冷へとシフトしていくことが予測できます。

まとめ

次世代データセンターのスタンダードへ

DLC(Direct Liquid Cooling)は、単なる新しい冷却技術ではなく、高発熱化と環境負荷低減という現代の二大課題を同時に解決する、次世代データセンターの必須インフラです。

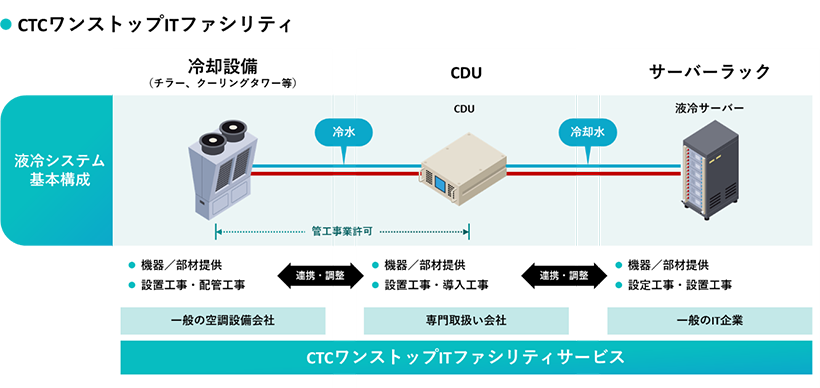

CTC伊藤忠テクノソリューションズ株式会社では液冷ソリューション「cooliquid(クーリキッド)」の提供を開始しておりCTCテクノロジー株式会社も液冷ソリューションの構築や保守、運用サービスの提供準備を進めています。

次世代データセンターの液冷ソリューション cooliquid(クーリキッド)

リンク: https://www.ctc-g.co.jp/keys/download/cooliquid

すでにDell、 HPE、Supermicro、Lenovo、Fujitsu(エフサステクノロジーズ)といったメーカーと、Quanta、GigaComputing、MiTAC Computingといった台湾メーカーの製品を提供可能となっています。

※CTCはマルチベンダー対応です。

※本ページに記載されている社名、製品名などは、一般に各社の表示、商標または登録商標です。

ENGINEERS' COLUMN 記事一覧

-

vol.7

公開日:2026/02/27

SSLi(SSL Inspection)を活用した際に見えてきた課題とポイント

SSLiは、暗号化されているHTTPS通信を一度復号し、HTTPとして可視化する技術です。これにより、通信内容を内部で確認し、マルウェア検査や不審なアクセスの検知を行うことが可能になります。

- セキュリティ

View More

-

vol.6

公開日:2026/02/16

バックアップの進化 ― ランサムウェア時代に求められる新常識

近年、各種メディアの報道でも取り上げられているように、ランサムウェアによるITシステムへの攻撃は、企業にとって最も深刻な脅威の一つとなっています。被害を受けた場合、サービスの再開には長期間を要するケースも多く、その社会的影響や企業が負うコストは非常に大きいものです。そのため、これまで以上にセキュリティ対策を強化する重要性が高まっています。

- セキュリティ

- 運用

View More

-

vol.5

公開日:2026/01/19

Blast‑RADIUS脆弱性対応に伴うFortiGateのRADIUSクライアント仕様変更とその影

FortiGateは、Fortinetが提供する次世代ファイアウォール(NGFW)であり、ネットワークの境界防御や脅威対策を担うセキュリティ製品として、さまざまな企業・組織で利用されています。CTCテクノロジー株式会社では、FortiGateをはじめとするFortinet製品の保守サポートサービスを提供しています。

- セキュリティ

- 運用

View More

-

vol.4

公開日:2025/12/24

ITインフラ機器のOSのバージョン選定

「ハードウェアのサポート終了はまだ先なのに、そこで動いているITインフラ機器のOS(ファームウェア)のバージョンのサポート期間が終了している」このような話を聞いたことがある(または指摘されたことがある)方も少なくないのではないでしょうか。

- 運用

View More

-

vol.3

公開日:2025/12/10

データセンターに液体?高発熱化するサーバーを冷やす「液冷」とは

“なぜ今、液体なのか?”を起点にDLC(Direct Liquid Cooling:直接液冷)の具体的な仕組み、そしてそれがデータセンターにもたらすメリットについて解説します。

- サーバ

View More

-

vol.2

公開日:2025/11/10

CPU・GPU・DPUの違いと役割のおさらいから多様化するプロセッサの最適利用について

皆さんはCPU・GPU・DPUといったワードをどのくらい頻繁に目にしますか? 近年、サーバーやストレージシステムの設計において「CPU(Central Processing Unit)」だけではなく、「GPU(Graphics Processing Unit)」や「DPU(Data Processing Unit)」といった多様なプロセッサの組み合わせ(もしくはそれらを搭載した製品の利用)がずいぶん一般的になってきたと思います。

- アーキテクチャ

View More

-

vol.1

公開日:2025/10/10

ストレージの容量が解放されない?! ― 確認したい2つのポイント

時々「ファイルを削除したのにストレージの容量が解放されない」といったお問い合わせをいただくことがあります。原因はいくつかあるのですが、一般的によくある原因の2つを紹介します。

- サーバ

- ストレージ

View More